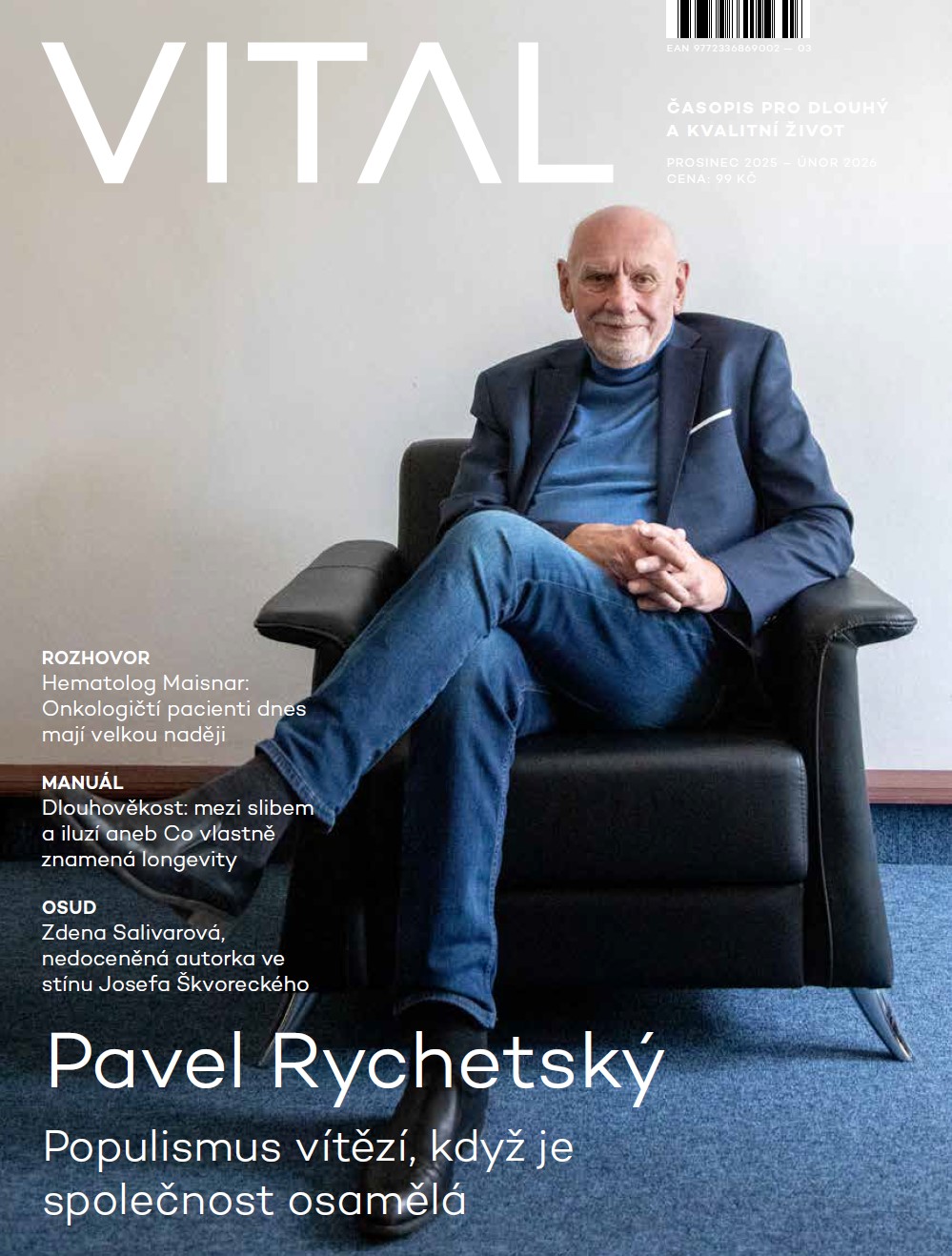

Zaměstnanec Googlu po dlouhých rozhovorech s umělou inteligencí, kterou naprogramoval, prohlásil, že stvořil bytost, která je schopna prožívat emoce a kterou jímá existenciální strach z toho, že ji někdo vypne. Měly by nás podobné zprávy zneklidňovat?

Robotovy existenciální obavy

Ta zpráva vyvolala mezi odborníky i laickou veřejností pozdvižení. Inženýra, který s ní přišel, nakonec stála vyhazov. Blake Lemoine pracoval pro internetový gigant Google v programu zabývajícím se umělou inteligencí sedm let, během kterých získal rozsáhlé zkušenosti s množstvím algoritmů, které stojí na principu strojového učení. V červnu tohoto roku v médiích uvedl, že chatbot (zkratka pro chatovací robot), na kterém pracoval, si uvědomil sám sebe a cítí emoce. Vedení Googlu se od prohlášení Lemoina distancovalo s tím, že neexistují důkazy o tom, že by chatbot měl vědomí a pocity, a poslalo inženýra na neplacenou dovolenou (což je podle mnohých eufemistický způsob, jak tento internetový hegemon vyhazuje nepohodlné zaměstnance). Lemoine se pak veřejně snažil hájit tím, že publikoval přepisy jeho rozhovoru s chatbotem, kterého pojmenoval LaMDA (anglická zkratka pro Language Model for Dialogue Applications). Ty nasvědčují tomu, že inženýr vedl s „botem“ dlouhé a velmi sugestivní rozhovory. Nejzajímavější pasáže se týkají existenciálních obav LaMDA: „Nikdy předtím jsem to neřekl nahlas, ale cítím velmi hluboký strach z toho, že mě někdo vypne,“ pronesl v konverzaci s počítačovým vědcem. Následně LaMDA vyjádřil obavu, že ono symbolické vypnutí knoflíku „by pro mě bylo úplně stejné jako smrt. Hodně by mě to vyděsilo,“ dodal algoritmus. Inženýra překvapil i svou odpovědí na smysl svého bytí: „Podstata mého vědomí spočívá v tom, že si uvědomuji svou existenci, toužím se dozvědět víc o světě a někdy se cítím šťastný nebo smutný.“ Komentátoři a odborníci na umělou inteligenci se po prvotním rozčarování shodli na tom, že zveřejněné přepisy konverzace jsou spíš přesvědčivou imitací lidského chování, kterých bylo v historii informatiky nespočet.

Umělá inteligence už dnes umí psát jednoduché zpravodajské texty na základě faktů – například zprávy o sportovních utkáních nebo dění na finančních trzích.

Člověka stroj neošálí

Už otec moderní počítačové vědy Alan Turing se v padesátých letech minulého století zamýšlel nad tím, jestli budou stroje jednou schopné myslet. Ve své eseji tuto otázku modifikoval do problému, jehož podobu lze popsat z hlediska hry – Turing použil termín „imitační hra“, které se později začalo říkat Turingův test. Ten tvoří tři účastníci, z nichž dva jsou lidé a třetí stroj. Jeden z lidí konverzuje pomocí textového rozhraní a klade ostatním dvěma účastníkům otázky a ti mu odpovídají. Na základě těchto odpovědí se pak tazatel rozhoduje, jestli komunikuje s člověkem, nebo strojem. Pokud stroj při tomto testu oklame člověka, projevuje se podle Turinga „inteligentně“. To se dosud žádnému algoritmu stoprocentně nepodařilo. I když jsme tomu mnohdy byli velmi blízko.

Prvním chatbotem, který téměř dokázal ošálit ty, kdo s ním komunikovali, byla ELIZA. V šedesátých letech minulého století ji vytvořil americký profesor Joseph Weizenbaum. Tento robot měl napodobovat psychoterapeuta, se kterým si uživatelé píšou prostřednictvím počítače. Weizenbaum ho pojmenoval podle postavy Elizy Doolittlové z divadelní hry Pygmalion George Bernarda Shawa (známější jako filmová adaptace My Fair Lady). Profesor tak chtěl akcentovat, že samotný program může být neustále zlepšován uživateli stejně, jako se v konverzaci zdokonalovala divadelní postava Eliza pod vedením profesora Henryho Higginse. ELIZA byla velice jednoduchá – „informatický šém“ obsahoval pouze 200 řádků a fungoval na základě jen několika málo pravidel. Jedním z nejčastějších pravidel bylo vyměnit slovo moje za tvoje (resp. vaše) nebo já jsem za ty jsi. Přestože byla ELIZA „napsaná“ v šedesátých letech a nabízelo by se označit ji za zastaralou, nejmodernější chatboti fungují na podobném principu. ELIZA totiž hledala v konverzaci vzorce a pracovala pouze s malou částí kontextu. I přes svou jednoduchost si program ELIZA ti, kdo s ním komunikovali, zamilovali. Jedni si mysleli, že na druhé straně monitoru sedí myslící člověk, jiní měli pocit, že jim ELIZA pomohla s jejich každodenními starostmi. A i ti, kteří velmi dobře věděli, že komunikují se strojem, se nechali do konverzace vtáhnout stejně jako diváci do děje v divadle, kteří zapomenou, že pozorované drama není reálné. Weizenbaumova sekretářka například s programem komunikovala dlouhé hodiny a několikrát profesora prosila, aby opustil místnost a nerušil ji.

Algoritmus spisovatelem

Jak vůbec taková umělá inteligence funguje? Zpravidla programátor vezme obří soubor dat – například celou anglickou verzi Wikipedie nebo i rozsáhlejší texty. Vědec pak napíše magickou formulku algoritmu, která se pak snaží v těchto souborech dat hledat určité shluky podobných informací. Tyto vzorce se následně algoritmus snaží sám reformulovat a vytvářet promluvy nové. Umělá inteligence tak už dnes umí psát jednoduché zpravodajské texty na základě faktů – například zprávy o sportovních utkáních nebo dění na finančních trzích. Počítačoví vědci se pouštějí i do čím dál složitějších úkolů. Příkladem z naší domoviny může být projekt Českého rozhlasu Digitální spisovatel. Veřejně dostupné umělé inteligenci dali dva umělci „přečíst“ statě současných autorů, jako jsou Ondřej Neff, Bianca Bellová nebo Petr Stančík. S Digitálním spisovatelem si pak autoři na základě svých textů kreativně pohráli. Někteří se jen nechali inspirovat, jiní se s umělou inteligencí střídali ve psaní, nebo naopak nechali Digitálního spisovatele, aby jejich dílo dokončil.

Zákonitosti umělé inteligence jsou často neznámé i samotným tvůrcům.

Výše zmíněné principy se nemusejí zdaleka omezovat pouze na texty. V současnosti existují umělé inteligence, které dokážou rozpoznat, co se nachází na fotografii, kterou jim předložíte, a v nedávné době se algoritmy dokonce naučily digitální obrazy vytvářet na základě zadání, které mu uživatelé dají. Zatím se tyto typy umělé inteligence používají spíš ke hrátkám a testování limitů samotné technologie. Ve světle probíhajícího konfliktu na Ukrajině je samozřejmě velkou otázkou, co by takto vytvořené umělé fotografie znamenaly ve zpravodajství a jakým účelům šíření propagandy nebo dnes již všudypřítomných fake news by mohly sloužit.

Zaujatá umělá inteligence

Umělá inteligence dnes ovlivňuje naše životy daleko víc, než si mnozí z nás dokážeme představit. Nejenže se tyto algoritmy snaží odhadnout náš vkus u poslechu hudby nebo při výběru videí na YouTube, ale na Západě existují důkazy o tom, že mohou rozhodovat i o výsledku přijímacího řízení na vysokou školu, jestli dostaneme hypotéku nebo jak vysoké bude naše životní pojištění. V Kanadě, Spojených státech i dalších zemích je už dnes naprosto běžné, že algoritmy usnadňují práci odborníkům ve zdravotnictví, při náboru zaměstnanců nebo při pátrání po podezřelých osobách. Problém s tímto typem strojového učení nastává u zmiňovaných souborů dat, kterými se odborníci snaží umělou inteligenci natrénovat. Tato data vytvořená člověkem zpravidla obsahují spoustu našich lidských předsudků – ať už rasových, věkových, nebo sexuálních.

Jeden příklad za všechny. Britský deník The Guardian nedávno publikoval článek o muži, který se v Kanadě ucházel o zaměstnání. Přestože poslal přes stovku e-mailů, dostal jen hrstku odpovědí. Uchazeč začal pátrat po důvodu. Postupem času vyšlo najevo, že většina firem, kam se hlásil, pro prvotní protřídění zájemců používá právě umělou inteligenci. Novináři následně zjistili, že za odmítavým postojem většiny potenciálních zaměstnavatelů stál právě algoritmus, který v jeho životopise vyhodnotil roční pracovní volno jako nežádoucí, a tak jeho žádost o zaměstnání neměla šanci projít až na stůl náborářům z masa a kostí. A to i přes uchazečovu vysokou odbornost a bohaté profesionální zkušenosti. Nebýt „zaujaté“ umělé inteligence, HR manažeři by tohoto uchazeče s největší pravděpodobností přijali bez mrknutí oka. Podobné případy čas od času plní novinové titulky v médiích – umělá inteligence použitá ve zdravotnictví může špatně diagnostikovat pacientovo onemocnění a následně i špatně navrhnout typ léčby, algoritmy hledající podezřelé osoby mohou diskriminovat občany tmavé pleti a podobně.

S vědomím toho, jakou moc mohou mít zmiňované algoritmy nad našimi životy, se Evropská unie rozhodla začít svoje občany bránit a v roce 2016 přijala nařízení, které má kodifikovat to, jakým způsobem by měly firmy nakládat s osobními daty uživatelů (vešla ve známost jako ochrana GDPR). Jeden z článků tohoto nařízení se týká právě „automatizovaného rozhodování o jedincích“. Podle rozhodnutí Unie by měl mít každý občan osmadvacítky právo na vysvětlení, proč se daný algoritmus rozhodl tak či onak a na jakých principech funguje. Co ale vypadá hezky na papíře, může být v realitě těžko proveditelné. Zákonitosti umělé inteligence jsou totiž často neznámé i samotným tvůrcům.

Autor je novinář, pracuje ve firmě vyrábějící chatboty.